Microsoft lanza nuevas soluciones para el desarrollo de una IA generativa "segura y confiable"

“La herramienta correcta en las manos correctas siempre ha sido sinónimo de innovación”, aseguran desde la tecnológica de Redmond.

La inteligencia artificial (IA), y lo generativo, están revolucionando la forma en que vivimos y trabajamos. Pero, igual que oportunidades, estas tecnologías generan usos nocivos y engrandecen el panorama de ciberataques, que también se ha democratizado y hace del cibercrimen uno de los negocios más lucrativos del momento. Desde Microsoft están convencidos de que la IA generativa “está cambiando la sociedad” y que hay que tener una aproximación responsable porque “la herramienta correcta en las manos correctas siempre ha sido sinónimo de innovación”. Según han contado en rueda de prensa diferentes responsables de la compañía de Redmond, desde dentro llevan trabajando en la IA desde hace ya muchos años para poder llegar a este momento “histórico” con diferentes aproximaciones y productos con seguridad desde el diseño, tratando este aspecto tanto desde las políticas y de gobierno interno, en la asociación con los distintos partners y en la ingeniería de las soluciones.

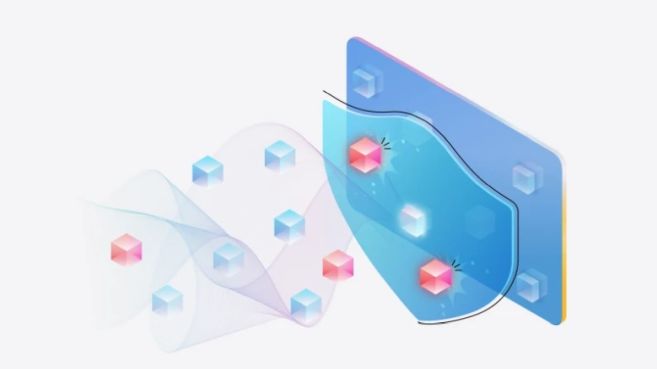

Con respecto a estos principios, la compañía ha lanzado nuevas aplicaciones para Azure AI que, entre otros usos, mitigan diferentes riesgos como las amenazas de inyección rápida, por las que los ciberdelincuentes tratan de manipular un sistema de IA para que haga algo fuera de su propósito, como producir contenido dañino o exfiltrar datos confidenciales. También ha lanzado sistemas que velan por la calidad y la confiablidad para asegurarse de “que los sistemas de IA no generen errores ni añadan información que no esté respaldada en las fuentes de datos de la aplicación, lo que puede erosionar la confianza del usuario.

Concretamente, estos nuevos anuncios que próximamente estarán disponibles en Azure AI Studio para desarrolladores de aplicaciones de IA generativa pasan, por ejemplo, por escudos de aviso (Prompt Shields) para detectar ataques de inyección u otros de aviso indirectos que afecten al modelo de lenguaje grande (LLM, de sus siglas inglesas); o un servicio para detectar las denominadas “alucinaciones” de estos modelos. También se publicarán mensajes del sistema de seguridad para orientar el comportamiento del modelo hacia resultados seguros y responsables o evaluaciones de vulnerabilidad de las aplicaciones a ataques jailbreak y a la generación de contenidos de riesgo. Por último, un sistema de supervisión de riesgos y seguridad para comprender qué entradas, salidas y usuarios finales del modelo desencadenan filtros de contenido para informar sobre las mitigaciones.